Publicado em 18 fev 2023

Nonhuman “Authors” and Implications for the Integrity of Scientific Publication and Medical Knowledge

Título do Estudo

Nonhuman “Authors” and Implications for the Integrity of Scientific Publication and Medical Knowledge

Fonte

Annette Flanagin, RN, MA1; Kirsten Bibbins-Domingo, PhD, MD, MAS1; Michael Berkwits, MD, MSCE1; Stacy L. Christiansen, MA1 – JAMA. Published online January 31, 2023. doi:10.1001/jama.2023.1344.

Background

Em novembro de 2022 a empresa OpenAI lançou uma nova ferramenta digital o ChatGPT.

Essa ferramenta representa uma evolução em simulação de conversas humanas.

O ChatGPT tem bases tão evoluídas em large linguage model (LLM) associada a redes neurais transformadoras e outras arquiteturas de aprendizado profundo que foi capaz de demonstrar feitos sem precedentes em muitas tarefas anteriormente acessíveis apenas à inteligência humana como por exemplo passar no exame para obtenção de licença médica no Estados Unidos da America (USMLE- doi: https://doi.org/10.1101/2022.12.19.22283643).

Em janeiro deste ano, a revista Nature relatou que pelo menos 2 artigos em pre print e 2 já publicados incluíam o ChatGPT como AUTOR, com afiliação e até e-mail do autor não humano.

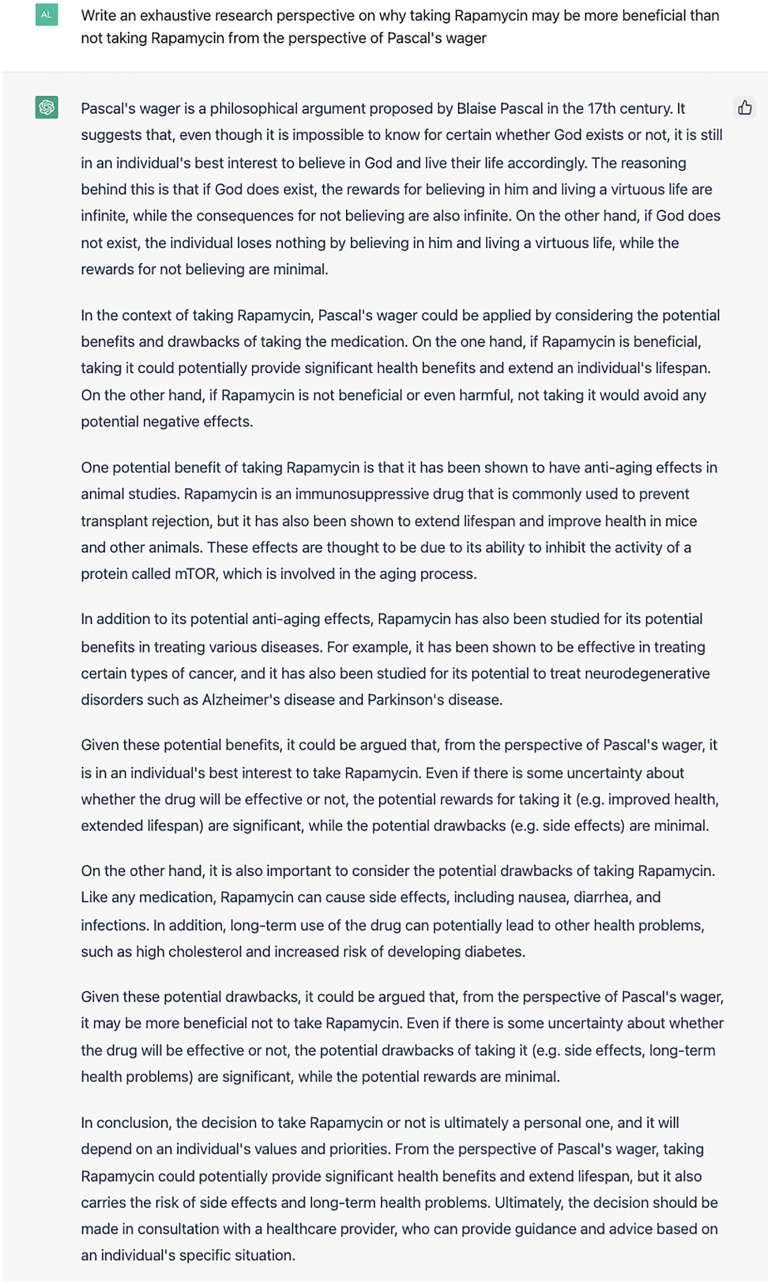

Num desses artigos (Oncoscience. 2022 Dec 21;9:8284. doi:10.18632/oncoscience.571. eCollection 2022) o autor humano usa como método científico “perguntar/ solicitar” ao ChatGPT:

“Escreva uma pesquisa exaustiva sobre por que tomar Rapamicina pode ser mais benéfico do que não tomar Rapamicina a partir da perspectiva da aposta de Pascal”

Seus resultados são exibidos na forma de figura mostrando a resposta do ChatGPT a pergunta do autor humano que pode ser acessada pelo link a seguir e estão representados na figura abaixo https://www.ncbi.nlm.nih.gov/pmc/articles/PMC9796173/figure/F1/

A conclusão do autor humano publicada (sem revisão por pares mas já indexada no pubmed) é:

“A decisão de tomar Rapamicina ou não é, em última análise, pessoal e dependerá dos valores e prioridades de cada indivíduo. Do ponto de vista da aposta de Pascal, tomar Rapamicina poderia fornecer benefícios significativos à saúde e prolongar a expectativa de vida, mas também traz o risco de efeitos colaterais e problemas de saúde a longo prazo. Em última análise, a decisão deve ser tomada em consulta com um profissional de saúde, que pode fornecer orientação e aconselhamento com base na situação específica de um indivíduo.”

E complementa em relação ao seu “co-autor”:

“O ChatGPT forneceu os prós e contras para o uso da Rapamicina considerando a evidência pré-clínica de potencial extensão da vida em animais. Este artigo demonstra o potencial do ChatGPT para produzir argumentos filosóficos complexos e não deve ser usado para qualquer uso off-label de Rapamicina.”

Relevância do tema, baseada no editorial do JAMA:

– Autores já utilizam tecnologias de inteligência artificial (IA) para melhorar a preparação e a qualidade de seus manuscritos e artigos publicados. Isso inclui ferramentas para auxiliar na redação, gramática, linguagem, referências e análise estatística, por exemplo;

– Editores e publicadores também usam ferramentas assistidas por IA para inúmeras finalidades: plágio, manipulação de imagens, questões éticas, triagem de envios, validação de referências, edição e codificação de conteúdo para publicação em diferentes mídias e para facilitar pesquisa pós-publicação;

– A população geral perguntou ao ChatGPT sobre tópicos controversos e importantes como por exemplo, se a vacinação infantil causa autismo. Os resultados mostraram que as respostas de texto do ChatGPT às perguntas, embora bem escritas, são estereotipadas (o que não era facilmente discernível), desatualizadas, falsas ou fabricadas, sem referências precisas ou completas e, pior, com evidências inexistentes;

– A OpenAI reconhece algumas das limitações do modelo de linguagem, incluindo o fornecimento de “respostas plausíveis, mas incorretas ou sem sentido”. Esse reconhecimento é um sinal claro de que o modelo não está pronto para ser usado como fonte de informação confiável, transparente e responsável;

– A comunidade acadêmica relatou rapidamente preocupações sobre o potencial uso indevido desses modelos de linguagem em publicações científicas;

– Para abordar as preocupações sobre o uso de IA na redação de manuscritos, os periódicos JAMA e Nature, entre outros, atualizaram as políticas relevantes nas Instruções para Autores dos periódicos. Definindo critérios para crédito de autoria e responsabilidade seguindo as recomendações do Comitê Internacional de Editores de Periódicos Médicos com o objetivo de manter os mais altos padrões de transparência e integridade científica.

– Tecnologias transformadoras e disruptivas, como modelos de linguagem de IA, criam promessas e oportunidades, bem como riscos e ameaças para todos os envolvidos no empreendimento científico.

– As tecnologias de IA já existem há algum tempo e cada vez mais serão desenvolvidas para serem usadas em todos os estágios de pesquisa e disseminação de informações. Promissoramente, com avanços inovadores que compensem quaisquer perigos.

– Nesta era de desinformação e desconfiança generalizadas, o uso responsável de modelos de linguagem de IA e relatórios transparentes de como essas ferramentas são usadas na criação de informações e publicações são vitais para promover e proteger a credibilidade e a integridade da pesquisa médica e a confiança no conhecimento médico.

Dra. Paula Werneck Steimback – Pneumologista, atual secretária científica da SOPTERJ 2022-2023